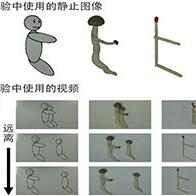

能否读取声音和周围的情况,并自发地采取照顾周全的行为?这一直是被认为正快速进化的机器人尚不如人类的领域之一。日本理化学研究所(以下简称“理研”)正致力于利用人工智能(AI)的核心技术深度学习来帮助机器人获得这种能力。希望让机器人能根据过去的信息做出判断,实现接近人类的互动。2050年有望实现善解人意的机器人。

“唠叨君,去门口看看”,当听到学生发出的指令后,“唠叨君”机器人边回答“真拿你没办法啊”,边朝着房间的门口方向移动,移动过程中还会介绍周围的情况,比如“这里有一个杯子、“我觉得房间里明亮又舒适噢”。这就是理研监护机器人项目(Guardian Robot Project)吉野幸一郎组长等人开发的互动机器人。

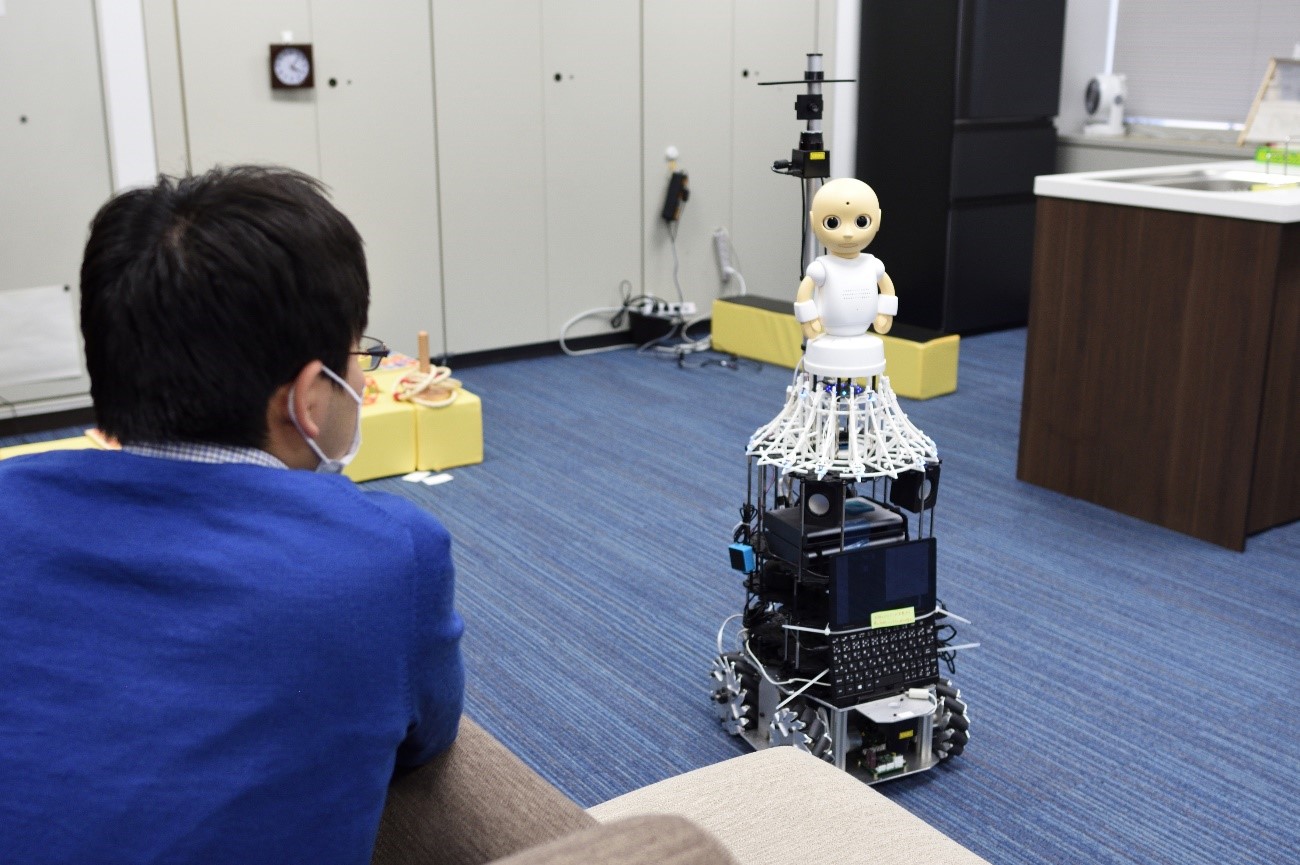

可以跟人对话的机器人“唠叨君”(图片由理研提供)

理研的“唠叨君”机器人拥有相当于人类的眼睛、耳朵和皮肤的功能。它配备了摄像头、麦克风以及检测亮度和温度的传感器等,并使用一种称之为“多模态整合”技术来收集外部信息,并结合起来。其特点是能识别眼前的人和物体等,并能做出回应。

以往的家用机器人和语音助手等APP是根据现有的模式和规则来回答问题。吉野组长介绍说:“以往的家用机器人和语音助手只能根据对方讲话的内容来判断如何回答,而无法考虑周围的情况。”

理研研究的是让如何机器人将过去的信息作为判断材料来回答。人们不仅根据他们在现场看到和听到的信息做出判断,还会根据过去的记忆等做出判断。理研按照人类的思考模式,让机器人也考虑过去的事情和学到的知识等。例如,听到“杯子在哪里”的问题后,会根据过去的图像信息,结合周围情况回答“应该在桌子上”或者“之前在厨房里看到过”。

人经常问一些模棱两可的问题或者说一些模棱两可的话,研究人员正在开发能对此作出妥善回应的AI。通过让其配对学习诸如“风景太美了”或“肚子饿了”等设想介绍观光信息的约3万条发言和回答,已经能以约90%的精度对问题做出妥善回应。如果将这种AI应用于机器人的话,它就能够执行贴心的行动,例如,当人口渴时,机器人就会提议说“我去帮你拿杯水吧”。

机器人能说出的内容和行动的选项越多,就越能告诉人们它为何采取这样的行动。这样,人也能理解机器人从周围的情况和声音中读取到了什么信息,以及是如何应对的。

目前的长期课题是让机器人自发地决定应该采取什么样的行动。比如房间里同时存在智能手机快要从桌子上掉下来和脱下的袜子被乱丢在地板上的情况时,它应该首先处理哪种情况?如果机器人知道智能手机掉下来可能会摔碎屏幕的话,它就能先移动到桌子的位置。

目前的机器人很难大量掌握这种“常识”。吉野组长预测说:“大约到了2050年前后,机器人才能作到像管家一样可以自主地解决问题。”

判断和行动的说明获得信赖

| 语音对话系统研究的历史与前景 | |

| 1960年代 | 开始推进人工智能起源的研究 |

| 1990~2010年 | 大力推进图像解析和语音识别等核心技术的开发 |

| 2010年代 | “Siri”等语音助手功能普及 |

| 2020年 | 通过深度学习,多项核心技术取得发展 |

| 2025年 | 机器人在无人的空间里工作,仓库货物装卸等实现全自动化 |

| 2030年 | 与人合作的机器人开始普及 |

| 2050年 | 开发出像管家一样的机器人 |

2010年代,AI通过自动提取学习数据特征的深度学习取得了飞跃发展。开发作为能呈现AI判断理由的“可解释AI(XAI)”,这一点不仅对机器人与人的沟通很重要,也是让人信赖AI系统的关键点。

AI越复杂,其过程就越容易黑盒化,说明理由就成了一个难度大无法推进的问题。尤其是医疗现场和金融机构都负有解释责任,需要明确出示判断的依据。因此亟需开发会说明理由的AI。

机器人也一样,理研的吉野组长表示,使其具备解释能力“有助于实现能与人类自然交谈和共生的机器人”。

美国国防部高级研究计划局(DARPA)正在推进有关可解释性的研究,加利福尼亚大学等也加入了其中。日本方面,NTT东日本和日立制作所于2021年9月启动了利用XAI和趋势数据创建AI预测模型以优化业务活动的验证实验。

随着新技术不断涌现,可靠性问题变得非常重要。虽然AI技术的发展变得难以预测和理解,但必须努力设法得到所有人的认可。

日文:高崎文、《日经产业新闻》,2022/01/21

中文:JST客观日本编辑部