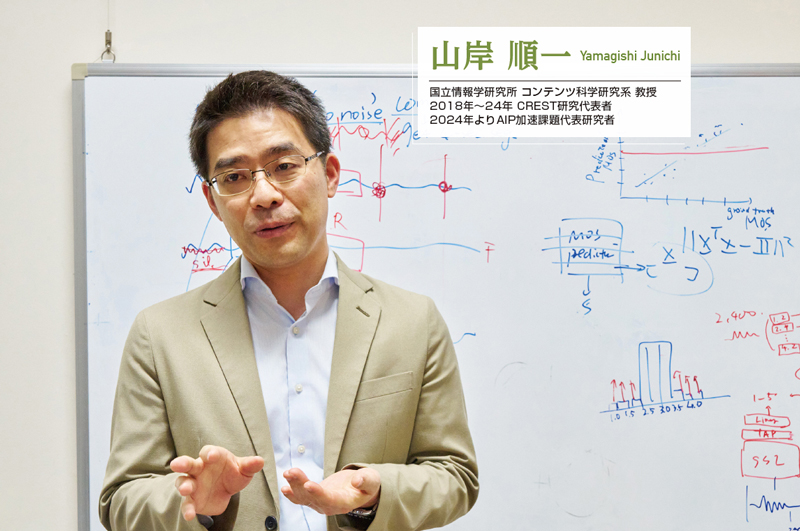

山岸 顺一

国立信息学研究所 内容科学研究系 教授

2018年~2024年担任CREST研究代表

2024年起担任AIP加速课题研究代表

近年来,足以以假乱真的伪造音频、图像和视频等“深度伪造”(Deepfake)内容被用于网络犯罪的情况开始出现。为了防止此类冒充他人的行为,推动数字技术的健康发展,隶属于日本大学共同利用机关法人信息与系统研究机构和国立信息学研究所内容科学研究系的山岸顺一教授从语音合成领域开始入手,开展并领导着多项旨在实现安全及个人隐私保护的研究开发工作。

语音合成技术取得飞跃性进步的同时其被滥用于犯罪的案例也开始出现

使用计算机将文本合成为语音的技术伴随着时代的发展取得了巨大进步。如今,这项技术已被广泛应用于机器设备等各类应用场景。特别是能够再现“个人特色”的语音合成技术,得益于计算机性能的提升与AI(人工智能)机器学习的进步更是取得了迅猛发展。现在,通过少量语音数据就能生成与本人高度相似的语音。近年来,通过自己的声音或已有音频数据生成AI语音克隆的面向一般公众的服务也开始被广泛使用。

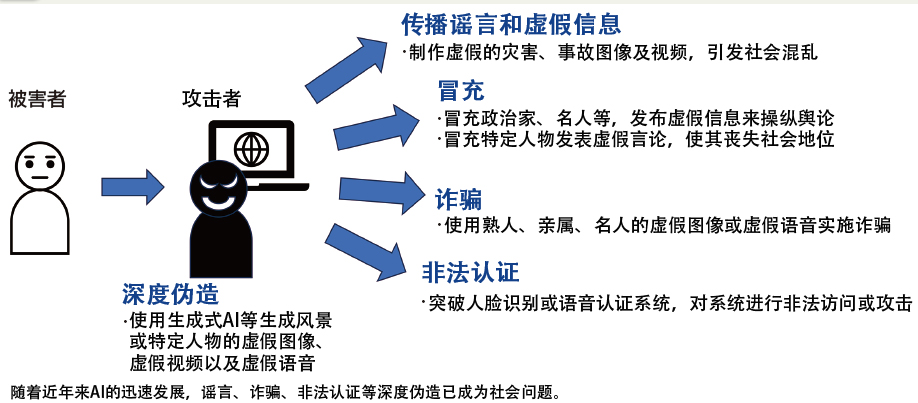

另一方面,对于高精度再现人声技术被恶意利用的担忧也日益加剧。比如通过冒充本人以欺骗语音认证系统或进行特殊诈骗的犯罪案例也陆续出现。2023年,美国联邦贸易委员会(FTC)曾发出警告称:“在冒充亲属的电话诈骗案件中,有部分案件有极大的可能涉嫌使用了人工合成语音。”事实上,近年来不仅是语音,克隆的图像和视频也能通过AI大量生成,带有恶意的深度伪造正逐渐成为社会问题(图1)。

图1:深度伪造正在演变为社会问题

此外,随着语音合成技术的进步,从互联网上公开的音频数据中识别出特定个人也已成为可能。针对这种情况,我们需要使用在语音公开之前预先对说话人信息进行处理的“ 说话人匿名化”技术来保护个人隐私。国立信息学研究所内容科学研究系的山岸顺一教授正在致力于解决这些与“声音”相关的各种问题,同时拓展语音合成技术的可能性。

采用“对抗竞争型研究”

利用相互对立的技术加速研发

学生时代兼顾学业与乐队活动的山岸教授,通过音乐演奏加深了对“声音”的兴趣。从此他立志从事以声音和信息处理为主题的研究,在东京工业大学(现东京科学大学)完成博士课程后,于2006年前往在语音技术研究方面有着悠久历史和卓越成就的英国爱丁堡大学继续研究。他回顾道:“在那里,我不仅进行了语音合成方面的研发,还与众多国外的研究人员建立起了人脉网络。”

回到日本后,山岸教授继续从事语音合成相关的研究。2018年,美国一家IT企业发布了一种基于神经网络的文本语音合成方法,合成出的语音与真人声音几乎没有差别。山岸教授的团队也发布了一种将神经网络与信号处理相结合的语音合成方法——“神经网络源-滤波器模型(NSF法)”予以抗衡。山岸教授表示:“至此,合成语音与真人声音的差异已经微乎其微,确立了能够实用的方法。

也就是在这个时候,尽管语音合成技术迎来了一个里程碑似的节点,但研究团队也处于决定下一阶段研究方向的岔路口。“在不断探索的过程中,我认识到随着语音合成技术的不断进化,未来它被‘恶意利用的风险’也随之增大”。于是,为了开发强化语音安全和隐私保护的新技术,山岸教授开启了JST CREST项目的研究。“一边消除有关声音的身份识别领域间的学科壁垒,一边通过提升说话人特征建模技术的精度,推进了提升语音生物认证安全性和可靠性的多项研发课题。”

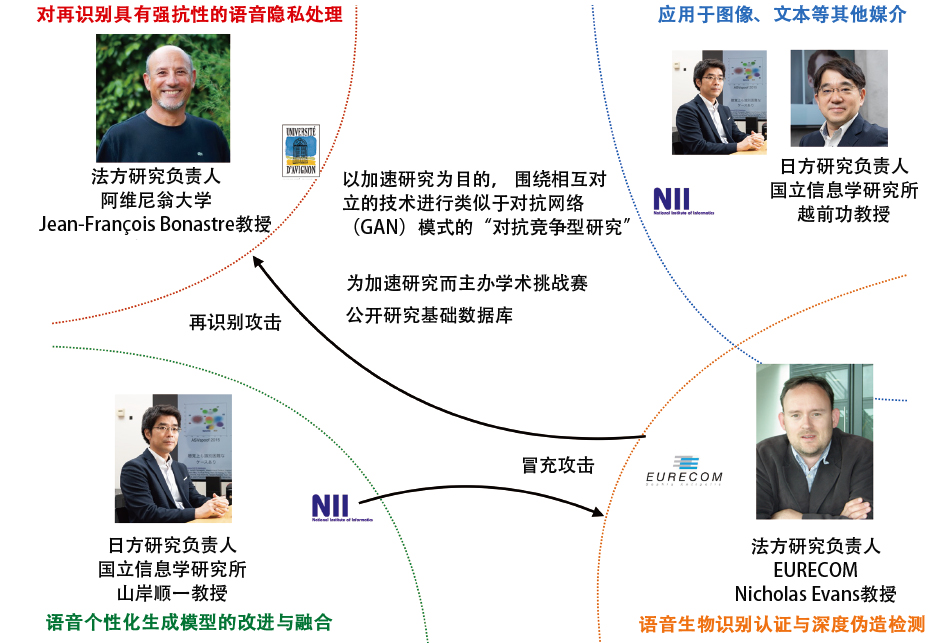

JST CREST项目的独特之处在于实现了一种“对抗竞争型研究”框架(图2)。

由日本国立信息学研究所、法国阿维尼翁大学以及法国研究中心EURECOM组成的日法联合研究团队,通过采用对立的技术 (against methods)来相互对抗,从而加速各自的研发进度。具体而言,当山岸教授的团队开发出新的语音合成模型时,他们将同步验证该模型是否能够突破生物识别认证,而与此同时EURECOM则会开发出更高级的生物识别认证技术来进行防御。此外,阿维尼翁大学还会开发出即便是这种高级生物识别认证技术也无法被识别出来的说话人匿名化技术——由此形成多重“矛与盾”的框架。

图2:项目体制

在该项目中,日本和法国的研究团队通过分别开发相互对立的技术,推进了能够相互提升彼此技术水平的“对抗竞争型研究”

山岸教授解释了该项目的目的:“我们认为,通过各团队使用各自开发的语音合成相关技术进行相互‘对抗’,不仅能提升研究成果的质量,还能进一步扩大其应用范围。”该项目分为四个课题展开研究与开发,目前已取得了一系列的成果。

语音增强和匿名化技术

在车站和电视节目中实际应用

第一个研究课题是为了再现声音身份而进行的生成建模技术融合与高精度化。除了能够同时执行语音合成和音质转换这两项不同任务的生成模型外,山岸教授的研究团队还提出了利用语音清晰度指标,在噪声中自动转换语音以使其听起来更为清晰的“语音增强”技术。进一步应用该技术,研究团队还开发出了在噪声中也能使听众清晰地听到合成语音的系统。该技术已被提供语音合成系统的日本IT企业采用,目前正运用于东海道新干线的车站站台广播中,实现了社会化应用。

第二个研究课题是提高基于语音的深度伪造检测技术。研究团队开发出了减轻安全风险的技术,并在防御技术的研发中取得了多项成果。其中一个成果是,构建了可用于训练深度伪造语音检测模型的大规模语音数据库。山岸教授表示:“该数据库自2019年发布以来,到目前为止已被下载约80万次,被广泛地用作标准数据库。”

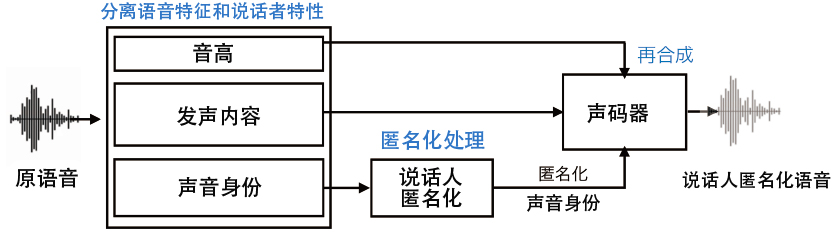

第三个研究课题是通过 说话人匿名化技术来保护语音隐私。现在,从公开的语音中识别个人身份或生成深度伪造语音变得越来越容易。为此,山岸教授团队开发了通过处理说话人信息来保护隐私的“ 说话人匿名化技术”(图3)。该技术已在日本广播协会(NHK)的节目中被用于对受访者的语音进行匿名化处理。既往的匿名化技术通常会将语音转变为类似于犯罪嫌疑人那样低沉且模糊的声音,而新技术成功实现了在保持语音清晰度的同时进行匿名化处理。

图3: 说话人匿名化技术框图

将语音分解为音高、发声内容、说话人身份这三个要素。在这些要素中,为了对真人声音的身份进行匿名化处理,使用了一种被称为“K匿名化”的方法。K匿名化是将个人被识别出来的概率转变为“K分之一”,其数值可以任意设定。声码器指的是用于分析和合成语音的技术或装置

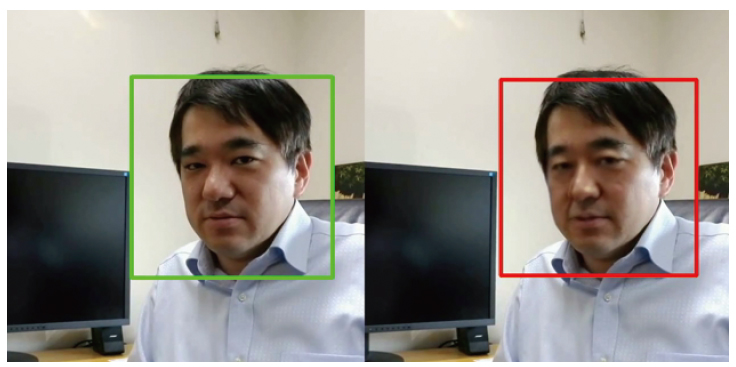

第四个研究课题是应用于图像、文本等其他媒介的深度伪造检测方法。目前,深度伪造的对象也在向图像、视频等领域扩展,“我们正在针对各种媒介,开发能够识破深度伪造的工具。”为此,研究团队开发出了实现深度伪造人脸的识别检测技术。此外,还开发出了能让用户轻松使用的深度伪造检测程序“SYNTHETIQ VISION”,并向多家公司提供了使用许可用于检测名人的深度伪造视频(图4)。

图4:SYNTHETIQ VISION的判定示意图

左侧绿框为真实图像,右侧红框是由深度伪造技术生成的伪造图像。肉眼无法区分其真伪

开发更先进的检测方法

挑战检测未知的深度伪造

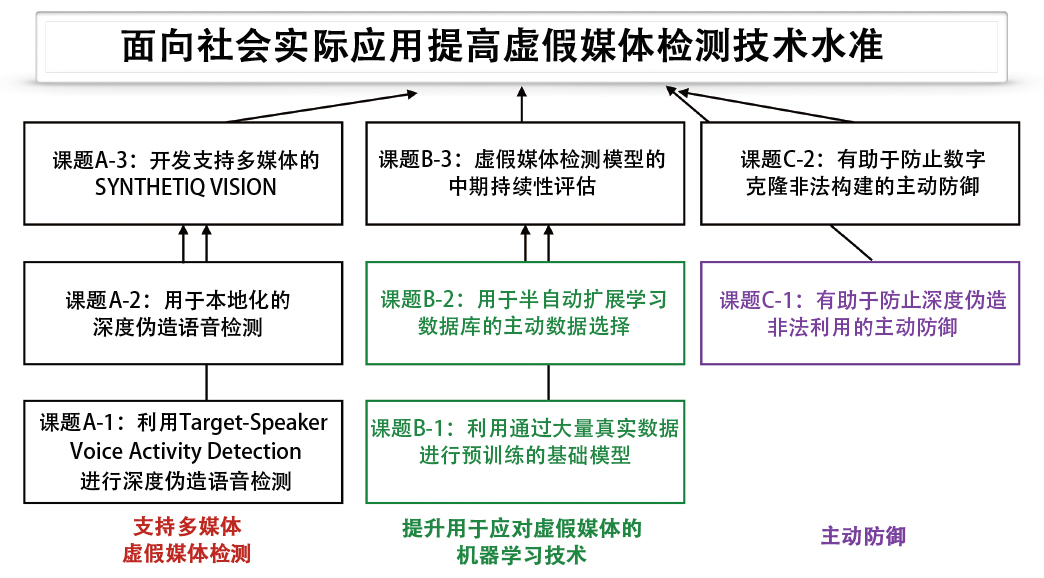

目前,在JST的AIP加速课题项目中,研究团队正在以加速和推广虚假媒体检测技术的社会应用为目标积极开展进一步的研发工作(图5)。山岸教授解释说:“作为此前CREST项目的强化与发展,在AIP加速课题项目中,我们不仅致力于将深度伪造检测技术应用于融合语音和视频的多媒体领域,还在开发能够应对未来可能出现的新型未知深度伪造的机器学习方法。”

图5:以实现社会应用为目标的AIP加速课题项目的研究设想

山岸教授在AIP加速课题项目中设定的目标。以实现更多的社会应用为目标,开发各种技术和实现机制

成果之一是开发出了一种能够应对新型深度伪造内容的机器学习算法。以往,要实现检测深度伪造的AI,需要向AI提供大量数据并让其进行学习。然而,即便在学习完成之后,要高精度地检测出新出现的未知深度伪造内容并非易事,还需要定期手动操作让检测模型进行重新学习。

对此,山岸教授的研究团队开发的算法能够让AI自身判断为检测新型深度伪造内容所需的训练数据,并自动扩展数据库。山岸教授谈到新算法的意义时表示:“通过这一算法,我们在实现能够追踪未知深度伪造内容的机制方面取得了重大进展。”此外,研究团队在检测虚假媒体的基础模型方面也取得了研究成果——他们构建了一个使用长达5万6000小时的人类真实语音和约1亿4200万张图像数据的基础模型并在此基础上推出了深度伪造检测模型。

“通过该模型,基于真实人类所独有的特征,我们实现了能够识破深度伪造语音和图像的技术。在图像检测方面,我们将误认率降低到了5%,实现了高精度检测。”除此之外,研究团队还在致力于开发验证图像及语音是否为原始内容的技术,以及还原深度伪造所使用的原始图像和语音的技术。

不固执于当前的研究领域

着眼于社会应用的广阔视野

在语音识别和合成领域,山岸教授一直勇于挑战符合时代需求的前沿研究,并取得了众多成果。自2018年入选CREST项目至今,他已发表了约160篇同行评审论文。其中,2018年发表的关于深度伪造视频检测模型“MesoNet”的论文,迄今为止已被引用超过了1600次。另一篇提出可同时实现深度伪造视频检测与篡改区域定位的“Capsule-Forensics”论文,更是在近五年内两次被评选为生物识别领域中最具影响力的论文。

尽管山岸教授的研究正按计划推进,但他坦言自己并非总是能提前规划好未来的研究活动。“大学时期,我曾憧憬成为一名音响工程师,甚至考虑过在录音棚工作。”即便后来走上了运用声音和信息处理方面知识的科研道路,2018年因语音合成技术达到一定水准,研究也曾一度陷入瓶颈。

然而,正是在那时找到了检测和防御深度伪造这一新目标,才成就了现在的众多成果。基于这段经历,他希望年轻研究者不要固执于当前的研究领域或研究风格,要时常思考“自己未来的方向在哪里”,并积极投入到日常的研究活动中。“我希望大家不仅专注于基础研究,更要为技术的社会应用付诸努力。”这是山岸教授对肩负着新一代科研重任的研究人员的寄语。(TEXT:佐宗秀海、PHOTO:石原秀树)

原文:JSTnews 2025年3月号

翻译:JST客观日本编辑部