东京工业大学的小池英树教授等人与美国卡内基梅隆大学等合作,开发了可以利用胸部佩戴的1台相机的影像来推测用户姿势的技术。人工智能(AI)通过识别广角鱼眼相机拍摄的影像中的四肢和头部等来推测用户的姿势。以前需要使用多个相机,或者穿着特殊的衣服拍摄,导入费用也比较高。预计新技术将用于运动和医疗现场等领域。计划2~3年后实现实用化。

推测人类运动过程中的姿势的技术称为“动作捕捉”。主要用于包含实际人体动作的动画制作现场等。在运动领域,有望用来分析比赛中的运动员的姿势,在医疗领域则有望用来掌握康复训练患者的状态。

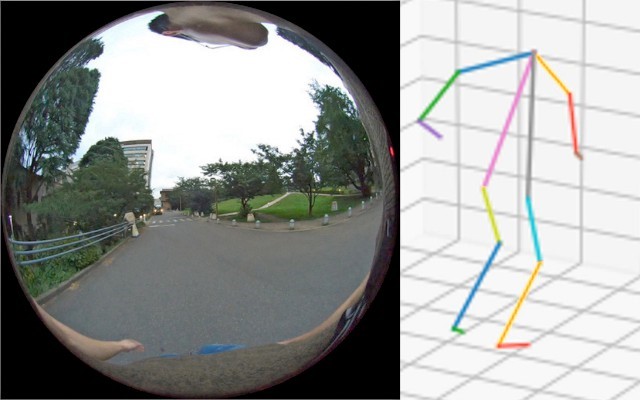

新方法是在用户的胸部佩戴视角为280度的鱼眼相机进行拍摄。影像中显示四肢和头部,AI会学习这些影像与姿势之间的关系。输入影像后即可输出用户的姿势。包括软件在内,预计导入费用只需几十万日元。

在胸部佩戴鱼眼相机拍摄动作=图片由东京工业大学的小池教授提供

AI的学习需要大量训练数据,这些数据要显示鱼眼相机拍摄的影像与姿势之间的关系。利用由68万张鱼眼相机图像构成的影像(使用三维CG(计算机图形)制作)和姿势数据进行学习。

完成学习后,研究团队向AI输入由实际佩戴鱼眼相机拍摄的1万6千张图像构成的影像,试着推测了姿势。以利用常规方法、即使用多台相机拍摄获得的姿势为准确数据,调查了新方法与之相比存在多大的误差。

各关节的误差平均约为8.5厘米。输入未学习的CG数据时,整体的平均误差约为4.4厘米。小池教授说:“通过增加学习数据或变更为实际数据,精度应该能进一步提高”。

AI会识别相机中拍摄的四肢和头部等(左)推测姿势(右)=图片由东京工业大学的小池教授提供

新开发的AI还可以将鱼眼相机的影像转换成人类平时看到的第一人称视角的影像。AI会推测用户头部的姿势,仅从鱼眼影像中检测用户所看的部分。然后合成第一人称视角的影像。小池教授说:“在运动等场景,所看的物体和方向大多很重要”。

以前为高精度推测运动过程中的姿势,一般是在房间的天花板和墙壁上固定多台高性能相机,然后穿着带有标记的衣服进行拍摄。导入费用高达数百万日元。也可以利用游戏用途等普及的红外传感器,但运动范围受限,很难在宽阔的空间移动使用。

日文:张耀宇、《日经产业新闻》、2020年11月11日

中文:JST客观日本编辑部